Han pasado algunos meses desde el lanzamiento de nuestra primera versión del detector de escritura con IA. En este tiempo hemos reafirmado nuestra estrategia de ser transparentes con la comunidad educativa sobre nuestros hallazgos y progresos, ya que estamos aprendiendo juntos sobre el impacto de la IA generativa. Como empresa, creemos que la entrega de información es fundamental para que los educadores puedan tomar las decisiones correctas para sus cursos y estudiantes.

Aprendizajes clave de esta etapa:

1. El 3,5% de los envíos contiene más de un 80% de texto escrito con IA.

Una pregunta que solemos escuchar es: "¿Cuánta escritura con IA ha aparecido en los envíos subidos a Turnitin?". Hasta el 14 de mayo de 2023, de los 38,5 millones de envíos que hemos procesado por escritura con IA, el 9,6% reporta más del 20% de escritura generada con IA, mientras que el 3,5% registra entre el 80% y el 100%.

Es importante considerar que estas estadísticas también incluyen trabajos en que el uso de herramientas con IA podría haber sido autorizado por los educadores. Sin embargo, decidimos no individualizar estos datos, debido a que no queremos catalogar estas métricas como "buenas" o "malas"; los datos son los datos. Por nuestro lado, seguiremos rastreando y publicando estos resultados e investigando otros elementos que pueden ser útiles para comprender las macrotendencias de la escritura con IA y su relación con malas conductas académicas tradicionales.

2. Educadores y administradores señalan que los falsos positivos son una de las principales preocupaciones en la detección de escritura con IA en general y en casos específicos en la solución de Turnitin*

Antes de lanzarlo a la comunidad, probamos nuestro modelo en un entorno de laboratorio controlado (nuestro Innovation lab). Pero, desde que salió al mercado, hemos descubierto que el uso de nuestro detector de escritura con IA en el mundo real está arrojando resultados diferentes a los del laboratorio. Hemos investigado artículos que fueron marcados por instituciones o educadores para una revisión adicional. Para reforzar nuestro marco de pruebas y diagnosticar tendencias estadísticas de falsos positivos, hemos sometido a nuestro servicio de detección 800,000 muestras de escritos académicos anteriores al lanzamiento de ChatGPT.

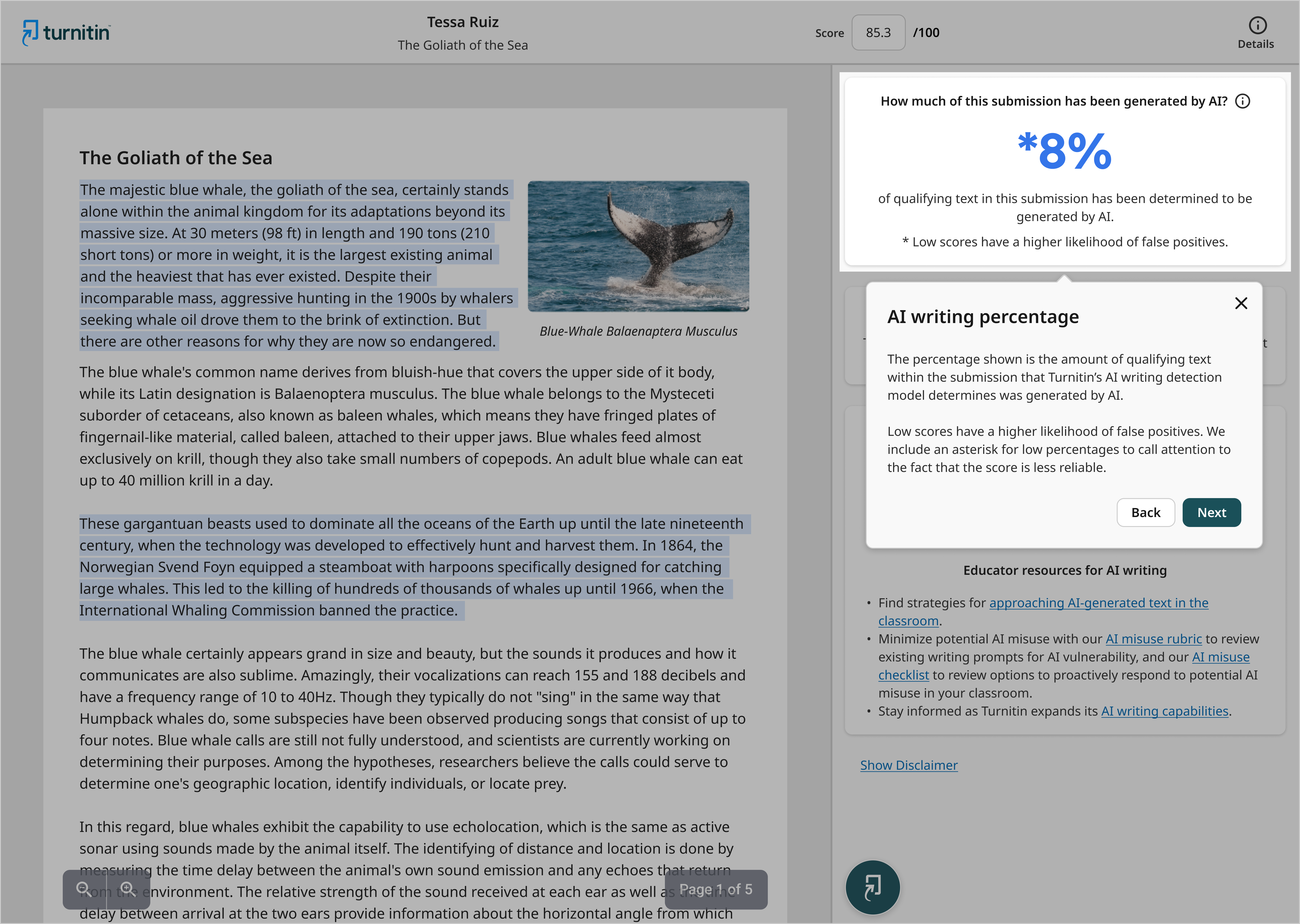

Como resultado de estas pruebas adicionales, hemos determinado que en los casos en que detectamos menos del 20% de escritura con AI en un documento, hay una mayor incidencia de falsos positivos. Se trata de un comportamiento inconsistente, por lo que seguiremos realizando pruebas para comprender la causa raíz. En tanto, para reducir la probabilidad de interpretaciones erróneas, hemos actualizado el botón del indicador de IA en el Reporte de Similitud para que contenga un asterisco en los porcentajes inferiores al 20%, con el objetivo de generar alerta sobre una puntuación menos fiable.

Consideramos varias opciones para este escenario, incluyendo dejar de mostrar una puntuación cuando detectamos menos del 20%, pero la respuesta de los educadores fue rotunda: no les gustaba la idea de las puntuaciones ocultas porque les quitaba la oportunidad de tener más información y ejercer un juicio académico.

Otro cambio que estamos haciendo tras analizar nuestros datos y pruebas es aumentar el requisito mínimo de palabras de un texto de 150 a 300 palabras para que pueda ser evaluado por nuestro detector de escritura con IA. Los resultados muestran que nuestra precisión aumenta cuando se trata de un texto más largo, sumado a que nuestro objetivo es centrarnos en la escritura de formato extenso. Es posible que con el tiempo vayamos ajustando este requisito mínimo de palabras en función de la evaluación continua de nuestro modelo.

También observamos una mayor incidencia de falsos positivos en las primeras o últimas frases de un documento. Muchas veces, estas frases son la introducción o la conclusión de un trabajo. Así que hemos cambiado la forma de agregar estas frases específicas para la detección, con el fin de reducir los falsos positivos.

En resumen, estas son las actualizaciones en las que hemos trabajado para dar respuesta a las preocupaciones de nuestros clientes sobre los falsos positivos:

- mostrar un asterisco en el indicador para los documentos en los que se detecta menos de un 20% de escritura AI,

- aumentar el requisito de palabras mínimas de 150 a 300, y

- ajustar la forma de agregar frases al principio y al final del documento.

3. Los educadores tienen dificultades para interpretar nuestras métricas de escritura con IA

En primer lugar, creemos que es importante explicar y aclarar que se calculan dos estadísticas diferentes: (1) a nivel de documento y (2) a nivel de frase. Cada una de ellas tiene asociada una métrica de escritura con IA.

Considerando los cambios anteriores y conociendo cómo interpretan los educadores nuestras métricas, hemos actualizado la forma en que hablamos de las tasas de falsos positivos para los documentos y para las frases. En el caso de los trabajos con más de un 20% de escritura con IA, nuestra tasa de falsos positivos de documentos es inferior al 1%, tal y como validó una prueba reciente de 800.000 trabajos previos a ChatGPT. Esto significa que 1 de cada 100 documentos escritos por humanos podría ser marcado como escrito con IA. Aunque un 1% es poco, detrás de cada falso positivo hay un estudiante real que puede haber puesto verdadero esfuerzo en su desempeño. No podemos mitigar completamente el riesgo de falsos positivos dada la naturaleza de la escritura y el análisis de la IA, por lo que es importante que los educadores utilicen la puntuación arrojada por el detector de escritura con IA para iniciar un diálogo significativo e impactante con sus alumnos en tales casos. También deben planificar cómo abordar dicha conversación, para eso, este recurso puede resultarles útil: Guía para abordar en clase textos generados con IA

Nuestros clientes nos han pedido estadísticas más detalladas sobre los falsos positivos: en concreto, cuál es la probabilidad de que una frase se marque como escrita con IA cuando en realidad ha sido escrita por un ser humano. Se trata de una métrica distinta de la tasa de falsos positivos a nivel de documento.

Nuestra tasa de falsos positivos a nivel de frase es de aproximadamente 4%. Esto significa que la frase que marcamos puede estar escrita por humanos 4 veces por cada 100 frases destacadas. Esta incidencia es más común en documentos que contienen una mezcla de contenido escrito por humanos y con IA, especialmente en las transiciones de contenido. Se trata de un área interesante que tenemos previsto investigar más a fondo, ya que existe una correlación entre estas frases y su proximidad en el documento:

- El 54% de las frases falsas positivas se encuentran justo al lado de la escritura real con IA

- El 26% de los falsos positivos se sitúan a dos frases de distancia de frase escrita con AI

- El 10% de los falsos positivos se encuentran a tres frases de la AI

- El 10% restante no está cerca de ningún escrito con IA

Entonces, ¿cuál es el "por qué" para los educadores? Cuando una frase aparece resaltada como escrita con IA, hay alrededor de 4% de posibilidades de que la frase haya sido escrita por humanos, pero la mayoría de los casos estarán muy cerca de un texto escrito con IA real. Tenemos previsto experimentar y probar diferentes experiencias de usuario en los próximos meses para ayudar a los educadores a comprender mejor esos puntos de transición. Mientras tanto, recomendamos a los académicos analizar las áreas resaltadas en el documento en su totalidad cuando visualicen un envío.

Comparto esta información para demostrar el rigor al que se someten nuestros tecnólogos para comprender mejor el "por qué", de modo que podamos seguir mejorando y guiando a los educadores con datos fiables y el contexto adecuado para facilitar el significado. Como parte de nuestra mejora continua a medida que los LLMs y la escritura con IA siguen evolucionando, nuestras métricas también lo hacen, en particular las relacionadas con el umbral de escritura con IA del 20%, el requisito de recuento de 300 palabras y la tasa de falsos positivos a nivel de frase de alrededor de 4%.

4. Los educadores se sienten inseguros al momento de tomar medidas cuando descubren escritura con IA en los trabajos académicos.

Entendemos que, como comunidad educativa, nos encontramos en territorio desconocido. Por eso, hemos publicado algunos recursos gratuitos para ayudar a profesores e instituciones a navegar por estas aguas:

- Cómo hablar con un estudiante sobre el posible uso indebido de la IA: Esta guía ayuda a propiciar un diálogo honesto y abierto con los estudiantes sobre su trabajo, evitando que alguna de las partes se ponga a la defensiva durante una interacción que podría ser difícil

- Ideas de debate para una conversación difícil sobre IA: Esta guía ayuda a los educadores a centrarse en la mejora del trabajo presentado y a facilitar conversaciones productivas.

- Conversemos sobre IA: ¿Cómo pueden los educadores manejar los falsos positivos?: Esta guía comparte estrategias que los educadores pueden utilizar antes y después de las evaluaciones o cuando descubren un falso positivo.

- Conversemos sobre IA: ¿Cómo pueden los estudiantes manejar los falsos positivos?Esta guía para estudiantes comparte estrategias que pueden utilizar antes y después de los envíos o cuando se enfrentan a un falso positivo.

- Lista para estudiantes sobre el uso ético de la IA: Esta lista de revisión para estudiantes ofrece orientación durante todas las fases del trabajo y les recomienda formas para tomar decisiones que apoyen la integridad y que se ajusten a las directrices del educador.

Por otra parte, invitamos a la comunidad de profesores a unirse al debate sobre la escritura con IA en la Red de educadores de Turnitin.

Seguiremos compartiendo información sobre nuestros aprendizajes, actualizaciones, cambios y replanteamientos mientras recorremos juntos este viaje hacia el futuro.

Annie Chechitelli

Directora de Producto, Turnitin

*Esta funcionalidad está disponible para contenidos desarrollados en Inglés